Otóż jak się okazuje standardowy plik robot.txt który jest w Joomla będzie się sprawdzał tylko dla stron podstawowych, a te które są już rozbudowane wymagają ingerencji właśnie w ten plik.

Google bierze tak dużo czynników do pozycjonowania że każdy niuans się liczy, zważywszy że strony teraz muszą być widoczne na wszystkich urządzeniach od telefonu po desktop.

Ostatnio odwiedziłem sobie narzędzia webmasterskie każdy kto ma stronę powinien mieć tam konto i zaglądać dość często aby analizować błędy i je naprawiać. To tyle słowem wstępu przejdźmy do analizy tego co chce wam przekazać i co mnie zdziwiło a po raz kolejny utwierdziło że nie wolno ufać rozwiązaniom uniwersalnym. Każdy CMS jest takim narzędziem uniwersalnym czy tego chcemy czy nie i tylko od programistów zależy jako bardzo polubi się z wielkim bratem GOOGLE!

Robot.txt

[su_blockquote]Robot.txt - mechanizm informowania automatów o tym, czego nie powinny robić na stronie www.[/su_blockquote]

Tak mówi nam Wikipedia i jest to prawie zgodne z prawdą. Bo raz że możemy zabronić to i możemy pozwolić! Służy do tego komenda Allow

User-agent: *

Disallow: /administrator/

Disallow: /cache/

Disallow: /cli/

Disallow: /components/

Disallow: /images/ # użyj jeśli chcesz aby obrazy były indexowane.

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /libraries/

Disallow: /logs/

Disallow: /media/

Disallow: /modules/

Disallow: /plugins/

Disallow: /templates/

Disallow: /tmp/

W takim wariancie robotowi zabrania się indexowania wszystkiego, co jest kłopotliwe bo blokowane są również css,js i np google może nie poprawnie widzieć naszą stronę dla mniejszych urządzeń.

[su_blockquote cite="Wypowiedź pracownika Google"]Don't block CSS, Javascript and other resource files by default. This prevents Google bot from properly rendering the page and understanding that it's optimized for mobile.[/su_blockquote]

Czyli sprawa jasna.

#Disallow: /images/ #taki zapis pozwoli robotowi indexowanie obrazów.

Pozostaje kwestia czy tego chcemy czy nie ale to już sprawa indywidualna.

W zasadzie jeśli używamy czegoś nie standardowego to trzeba przeanalizować plik robot.txt i narzędziach webmasterskich wy renderować sobie własną stronę wówczas będziemy mieli podgląd co jest nie tak.

Oczywiście nie idźmy na łatwiznę i nie # haszujmy wszystkiego jak popadnie. Narzędzia dokładnie powiedzą do czego robot dostępu niema. W tym wypadku chodziło o plugin Jch_optimize więc dodać trzeba dwie linijki kodu na początku.

Allow: /plugins/system/jch_optimize/assets/

Allow: /plugins/system/jch_optimize/assets2/

Drobna uwagą jak będziecie dodawać inne wpisy zwróćcie uwagę że duże i małe litery mają znaczenie czyli allow nie zadziała a Allow tak!

Najczęstszymi folderami które będą wywoływać błędy są cache, images, media, js (nie samej J! tylko komponentów firm trzecich)

Follow, Index

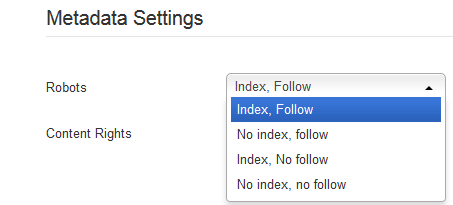

Budując stronę wypadało by nie zapraszać google, ponieważ raz zaindexowana stroną źle może długoooo się utrzymać w wynikach google więc w konfiguracji globalnej powinno się ustawić NOFOLLOW, NOINDEX

A po skończeniu prac i otrzymaniu wersji finalnej wizualnej strony z treścią gotową dla użytkownika końcowego ustawić follow, index

Zaawansowane ustawienia robot.txt

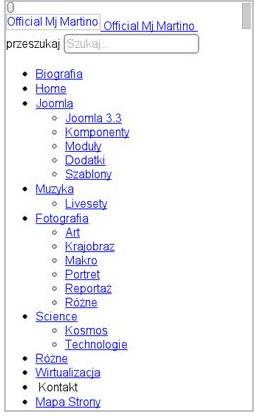

Można posłużyć się również ustawieniami pliku robot.txt aby uniknać duplikowania treści z linków NON-SEF czyli nie przyjaznych. Stosując zapis po niżej.

User-agent: *

Disallow: /*?*

Tutaj trzeba dodać że np może wystąpić problem z frameworkiem T3 i innymi które np generują odpowiednie JS.

Podsumowanie

Podsumowanie będzie proste pokaże jak wyglądała strona widziana przez google robota przed i po : )

PRZED

PRZED  PO

PO

PRZED

PRZED

PO

PO

Aby być poprawnym z google musiałbym zmienić szerokość strony na 970px ale wówczas jest strasznie dużo wolnego miejsca po bokach. Więc myślę że za niedługo będą obowiązywać nowe standardy szerokości, szczególnie że 4K jest w drodze na desktopy. Obecna szerokość to 1270px i dla szerokich ekranów 1470px (te szerokości obowiązuje u mnie na stronie.)

AKTUALIZACJA 08.2015

Można jeszcze dodać na początek robot.txt wpis.

/*.js

Allow: /*.css